Webクローラーの特徴を組み合わせたものです。このサービスでは、誰もが自由にコードをカスタマイズし、Webクローラーとはインターネット上に公開されているテキスト・画像・動画などの情報を自動で収集し、データベースに保管するプログラムのことです。さまざまなウWebクローラーがビッグデータのブームで重要な役割を果たし、人々がデータを簡単にスクレイピングできるようにしています。

さまざまなWebクローラーの中には、オープンソースのWebクローラーフレームワークがたくさんあります。オープンソースのWebクローラーを使用すると、ユーザーはソースコードまたはフレームワークに基づいてプログラミングでき、スクレイピング支援のリソースも提供され、データ抽出が簡単になります。この記事では、おすすめのオープンソースWebクローラーを10選紹介します。

オープンソースのWebクローラーとは

オープンソースのWebクローラーについて理解するには、「オープンソース」「Webクローラー」の概念をそれぞれ把握することが大切です。ここでは、オープンソースのWebクローラーについて詳しく解説します。

オープンソースとは

「オープンソース」とは、ソフトウェアのソースコードが公開されており、誰でも自由に利用、改変、再配布することができるタイプのソフトウェアです。これにより、多くの開発者が協力してソフトウェアを改善し、多様なニーズに応じてカスタマイズすることが可能となります。

Webクローラーとは

Webクローラーは、インターネット上のウェブサイトを自動で巡回し、情報を収集するプログラムです。このツールは、ウェブサイトからデータを集め、それを様々な目的で利用できるように整理します。主な用途としては、検索エンジンがウェブサイトの内容をインデックスする際や、データ分析のための情報収集などがあります。

すなわち、オープンソースのWebクローラーとは、オープンソースソフトウェアと特定の要求に応じて機能を調整することができます。

スクレイピングとの違い

Webクローラーと似た技術に「スクレイピング」がありますが、その目的は異なります。スクレイピングは、特定のウェブページから具体的な情報を抜き出すための技術です。一方、Webクローラーはインターネット上の広範囲にわたる情報を集めることに重点を置いており、より大規模な情報収集に適しています。

また、オープンソースのWebクローラーは自由にカスタマイズが可能で、さまざまなニーズに合わせて設定を変更できるため、幅広い用途で利用できる点がメリットです。

Webクローラーサービスの注意点

Webクローラーは、インターネットから情報を収集する強力なツールですが、使用する際にはいくつかの重要な注意点があります。ここでは、Webクローラーを使う上での基本的なルールと注意事項について解説します。

ウェブサイトのルールを守る

ウェブサイトにはrobots.txtというファイルがあり、これはクローラーがウェブサイトをどのように巡回してよいかのルールが書かれています。このルールに従うことで、ウェブサイトの運営者がクロールを望まないページを避け、スムーズに情報収集を行うことができます。

ウェブサイトに負担をかけない

クローラーは自動でウェブページにアクセスしますが、短時間で多くのページにアクセスしすぎると、ウェブサイトのサーバーに大きな負担をかけることがあります。サーバーに過度な負荷をかけないよう、アクセスの間隔を適切に設定しましょう。

法律を守り、個人のプライバシーを尊重する

収集する情報の中には、法的に保護されたデータや個人のプライバシーに関わる情報が含まれることがあります。法律を遵守し、特に個人データを扱う際には十分な注意を払い、必要な場合は許可を得ることが重要です。

最新の情報を保つ

ウェブサイトの情報は頻繁に更新されるため、収集したデータが古くならないように定期的にクローラーを実行し、データを更新することが必要です。

これらの注意点を理解し、適切に対応することで、Webクローラーサービスを効果的かつ安全に使用することができます。

オープンソースのWebクローラーサービス10選

オープンソースのWebクローラーは、ウェブから情報を収集するために使用されるツールであり、様々なプロジェクトで利用されています。これらのクローラーはソースコードが公開されており、誰でも自由に使用、改良することができます。ここでは、いくつかの有名なオープンソースWebクローラーを紹介し、それぞれの概要と特徴を解説します。

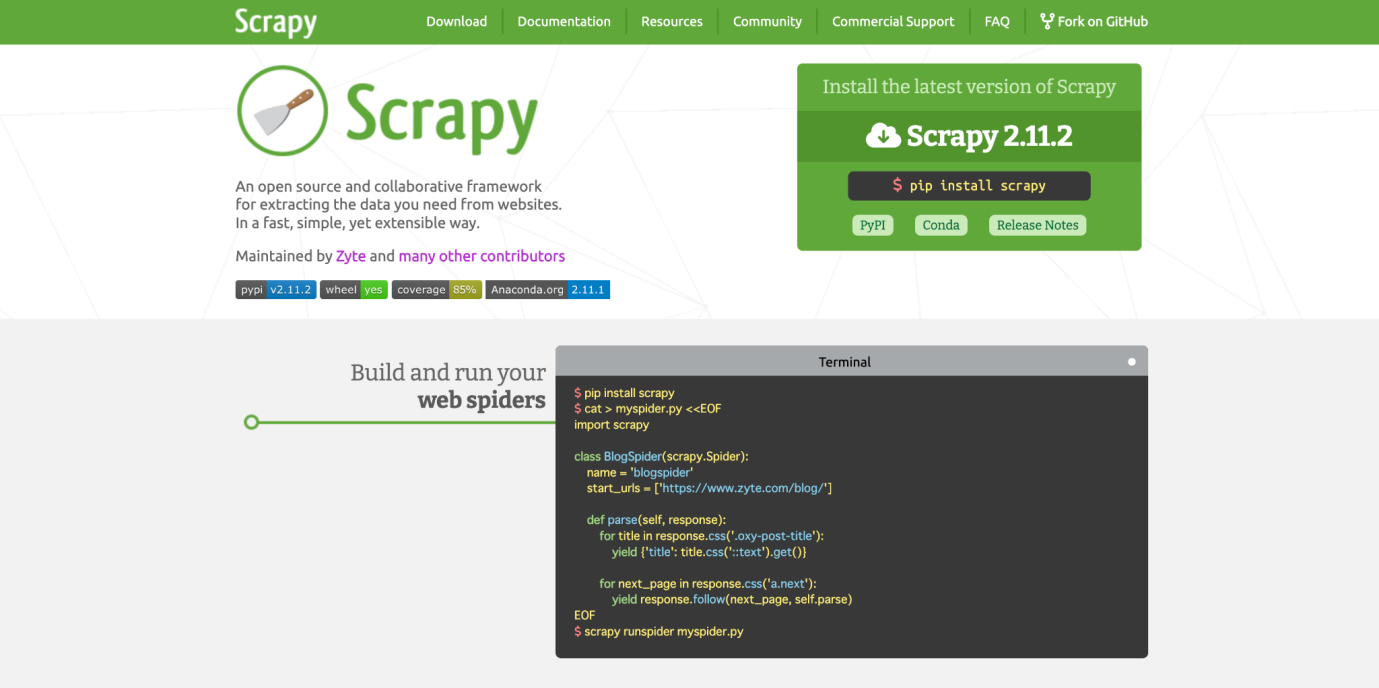

1.Scrapy

Scrapyは、ウェブサイトのデータを効率的に抽出し、管理するためのオープンソースのフレームワークです。Pythonで書かれており、柔軟で強力なクローリングとスクレイピングのニーズに対応する設計が特徴です。ユーザーは簡単にクローリングルールを定義でき、Scrapyが自動的にウェブページから必要なデータを収集します。開発者コミュニティも非常に活発で、多くの貢献者によるサポートが得られます。このツールは、特にデータ収集とウェブデータの解析を頻繁に行うプロジェクトに適しています。

特徴:

- 高速で強力:効率的にデータを抽出し、大規模なウェブクロールにも対応する能力を持っています。

- 拡張性が高い:ユーザーは独自の機能を簡単に追加でき、既存のコアシステムを変更することなくカスタマイズが可能です。

- ポータブル:Linux、 Windows、Mac、BSDで動作し、広範囲にわたる互換性を提供します。

2.Crawlee

Crawleeは、Node.jsで構築されたオープンソースのウェブスクレイピングおよびブラウザ自動化ライブラリです。このツールは、信頼性が高く効率的なクローラーの構築をサポートする設計がされており、特にモダンなウェブアプリケーションのスクレイピングに適しています。

- 拡張性とスケーラビリティ:Crawleeは、システムリソースに基づいて同時実行を自動的に管理し、プロキシのローテーションと人間のようなブラウザのフィンガープリントを使用して効率を向上させます。

- HTML解析とJavaScriptレンダリング:Cheerioライブラリとヘッドレスブラウザを活用して、HTMLの解析とJavaScriptが重要なページのレンダリングを行います。

- アンチブロッキング機能:本物のユーザーのように見せるための高度なアンチブロッキング機能を内蔵しており、ブロックを避けながらデータを確実に抽出できます。

3.MechanicalSoup

MechanicalSoupは、ウェブサイトとの自動化されたインタラクションを可能にするPythonライブラリです。このライブラリは、主にフォームの送信やリンクのフォローなど、シンプルなウェブスクレイピングタスクに適しています。

- 自動化機能:MechanicalSoupは自動的にクッキーを保持・送信し、リダイレクトを追跡し、リンクを辿ることができます。

- フォームのサブミット:ユーザーはフォームを容易に提出することができ、ウェブページ上でのログインやその他のインタラクションを自動化することが可能です。

- JavaScript非対応:JavaScriptを実行する能力がないため、動的コンテンツよりもシンプルなページの自動操作に適しています。

4.Heritrix

Heritrixは、インターネットアーカイブによって開発されたオープンソースのWebクローラーで、主にウェブアーカイビングの目的で使用されます。このツールは大規模な情報収集を目的とし、デジタルライブラリの構築を支援します。特に、デジタルコンテンツの保存とアクセスを目的としたプロジェクトや機関にとって価値あるツールです。

- 大規模なウェブアーカイビングに最適:Heritrixは、大量のウェブコンテンツを効率的に収集し、長期保存するために設計されています。

- 高度な設定オプション:ユーザーはクロールの挙動を詳細に設定でき、どのURLをクロールするか、データをどのように扱うかを厳密に管理できます。

- 大規模データセットの処理:広範囲のウェブを対象とした情報収集が可能で、特に図書館やアーカイブなどの機関での使用に適しています。

5.Nokogiri

Nokogiriは、Ruby言語で使用されるオープンソースのライブラリで、HTMLおよびXMLドキュメントの解析と操作を効率的に行うことができます。特にウェブスクレイピングやデータ抽出タスクに適しています。そのパフォーマンスと柔軟性から、Ruby開発者にとって役立つツールといえるでしょう。

- 効率的な解析:NokogiriはC言語で実装されたlibxml2と連携して動作するため、高速で正確な文書解析が可能です。

- 豊富な機能:HTMLやXMLの内容を簡単に検索、変更、抽出するための多様なメソッドを提供します。

- 広範な対応:多くのRubyプロジェクトで広く使用されており、大規模なコミュニティサポートと広範なドキュメントが利用可能です。

6.Apify

Apifyは、ウェブデータの抽出とAPI統合に特化したプラットフォームで、高度なウェブスクレイピングとブラウザ自動化の機能を提供します。このプラットフォームは、データ駆動型のチームやAIモデルのトレーニングに必要なデータを迅速に収集するための強力なツールです。

- データ収集とAIトレーニング:ウェブからのテキストや画像のデータを抽出し、大規模言語モデル(LLM)のトレーニングデータセット生成を支援します。

- 高度な統合機能:LangChainやLlamaIndexなどのベクターデータベースにデータセットを直接ロードすることで、AIチャットボットや他のアプリケーションを構築できます。

- 拡張可能なウェブスクレイピング:1,500以上の準備済みスクレイパーを通じて、検索エンジン、ソーシャルメディア、旅行サイトなどからデータをフェッチする機能を提供します。

7.PySpider

PySpiderは、強力でユーザーフレンドリーなPythonベースのウェブクローリングフレームワークです。WebUIを通じて簡単に操作可能で、複雑なクローリングタスクを効率的に処理する機能を備えています。PySpiderはその柔軟性と強力な機能で、データ収集が必要な様々なプロジェクトに利用されています。

- 簡単なセットアップと操作:PySpiderは pip を使用して簡単にインストールでき、コマンドラインやWebUIを通じて操作が可能です。

- タスクスケジューリング:自動化されたスクリプトを使用して定期的なクローリングタスクをスケジュールできます。例えば、特定のウェブサイトを毎日クロールすることが可能です。

- 詳細ページの優先的クローリング: priority オプションを使って、重要なページを優先的にクロールする設定ができます。

8.Node Crawler

Node CrawlerはNode.jsで構築された人気のあるウェブクローリングライブラリで、特に大量のウェブリクエストの効率的な処理に適しています。このライブラリは、高速で柔軟性があり、サーバー側でjQueryの機能を利用してHTMLを解析します。特に、大規模なウェブスクレイピングタスクに取り組む開発者に役立つツールです。

- 高効率な同時リクエスト処理:Node.jsの非同期モデルを利用して、多くのウェブページを同時にクロールし、効率的にデータを収集します。

- Cheerioとの統合:Cheerioライブラリと組み合わせて使用することで、HTMLコンテンツの解析とデータ抽出が容易になります。

- カスタマイズ可能なクローリングオプション:ユーザーエージェントの文字列やリクエスト間隔など、多岐にわたるカスタマイズオプションを提供し、様々なクローリングシナリオに対応します。

9.Crawler4j

Crawler4jは、Javaで開発されたオープンソースのウェブクローリングライブラリです。このツールは特に、簡単なAPIと設定オプションを提供し、Javaベースのアプリケーションに簡単に統合できます。特にJava開発者にとって使い勝手が良く、シンプルで効率的なウェブクローリングソリューションを求めるプロジェクトに適しています。

- 使いやすさ:Crawler4jは使いやすいインターフェースを提供し、最小限の設定でクローラーを迅速に立ち上げることができます。

- マルチスレッド対応:このライブラリはマルチスレッドをサポートしており、効率的に大規模なクローリングタスクを実行できます。

- ポライトネス設定のサポート:ウェブサイトへの訪問に際して節度をもって正しく振る舞うためのポライトネス設定を提供し、サイトの負荷を軽減します。

10.Apache Nutch

Apache Nutchは、Javaベースで高度に拡張可能なオープンソースのウェブクローリングフレームワークです。これは、大規模なウェブクローリングおよびデータ抽出タスクに特化しており、分散環境でのクローリングをサポートし、Hadoopとの統合が可能です。特に検索エンジンやデータ分析を行う大企業や研究機関での利用に適しており、複雑で広範囲なウェブクローリング要求に対応できる強力なツールです。

- 大規模データ処理:分散クローリングをサポートし、Hadoopと連携して大量のウェブデータを効率的に処理し、解析する能力を持っています。

- 高い拡張性:カスタマイズが可能なプラグインアーキテクチャを採用しており、特定のニーズに合わせてクローラーの機能を拡張することができます。

- 堅牢なコミュニティサポート:プロジェクトの一部として、活発な開発者コミュニティと広範なドキュメントが利用可能です。

まとめ:IT初心者はWebスクレイピングツールの活用がおすすめ

オープンソースのWebクローラーは、そのカスタマイズの自由度とコスト効率の良さから、多くのプログラマーやシステムエンジニアに重宝されています。これらのツールは複雑な設定やカスタマイズが可能であり、特に技術的な背景を持つユーザーには大きなメリットをもたらします。

しかし、オープンソースのWebクローラーサービスは、あくまで開発者向けに設計されており、プログラミングスキルが必要です。一方、ノーコードで利用できる「Webスクレイピングツール」も存在します。これらのツールは、直感的なインターフェースを通じてデータを抽出する機能を提供しており、非エンジニアでも簡単に使える点が魅力です。

例えば、Octoparseのようなツールでは、特定のウェブページから大量の情報をドラッグ&ドロップ操作だけで抽出できます。このように、大量のデータを収集したい場合は、自身の技術レベルやプロジェクトの要件に応じて最適なツールを選択しましょう。