Webスクレイピング(Webデータ抽出、データスクレイピングとも呼ばれる)とは、Webからデータを抽出し、Web上のデータをデータベースやスプレッドシートに格納・分析可能な構造化データへの変換するWeb技術です。

Webスクレイピング技術は、Webスクレーパー(Webクローラー)を構築するのによって実現されますが、プログラミングを知らない方にとって、この作業は難しいかもしれません。しかし幸いなことに、今ではコーディングを行わずともWebデータを自動抽出できるスクレイピングツールが数多く登場しています。

これらのツールの多くは簡単な操作だけで設定できる上、ツールによって機能や特徴も多種多様です。たとえば、クラウド型であればサーバーにシステムを構築せずとも、アカウント発行だけで利用可能です。

そこで今回はスクレイピングツール30選を一挙に紹介していきます。スクレイピングツール導入を検討中の方はぜひご覧ください。

チュートリアル:【Pythonクローラー入門】SeleniumによるWebクローラーの開発

初心者でも利用できるスクレイピングツール

1. Octoparse

【概要・特徴】

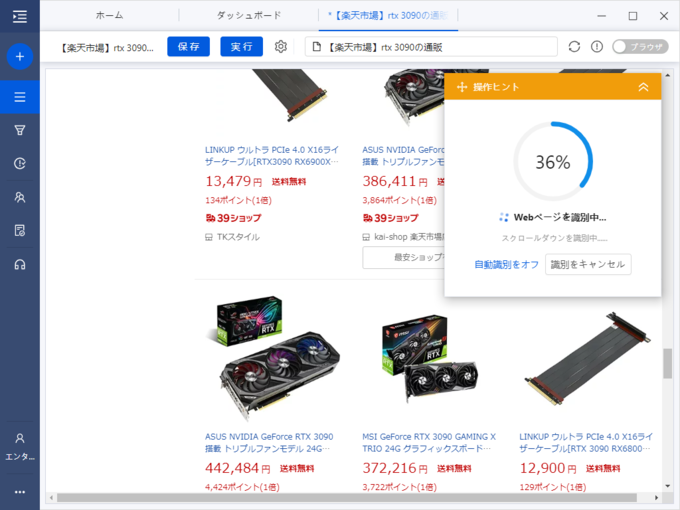

「Octoparse」はノーコードで使えるクラウド型Webスクレイピングツールです。Webページ自動識別機能を実装し、コードを書かなくてもマウス操作主体の設定だけで、かんたんにWebクローラーを開発できます。抽出したデータは、データベースやスプレッドシートに保存されるため、コピペ操作は不要です。

Octoparseでは、より手軽にWebスクレイピングを実施するために、Yahooショッピング、楽天、マイナビ転職、Twitter(The X)など数多くのテンプレートを利用できます。テンプレートを使えば、パラメータ(ターゲットページのURL、検索キーワードなど)を入力するだけで、Webスクレイピングを実行できます。

また、クラウド型プラットフォームのOctoparseは、24時間データ抽出が可能である上、数百台ものクラウドサーバーにサポートされ、クラウドでデータを抽出する際に追跡されるやアクセス拒否される可能性は最小限にされます。

スクレイピングツールの他に、OctoparseはWebデータサービスも提供しています。具体的なニーズに基づいてカスタマイズすることもできます。

プログラミングに詳しくない人にとってはすごく便利です。また、日本語サービスも提供しており、日本のユーザーにはやさしいですね。

【こんな方におすすめ】

プログラミングの知識・経験がない方、リスト作成などWeb上のデータを抽出を必要とする個人・企業

【公式サイトURL】

2. Beautiful Soup

【概要・特徴】

「Beautiful Soup」は、HTMLやXMLファイルをスクレイピングするために設計された、PythonのWebスクレイピング用のライブラリです。インターネット上のWebサイトの多くはHTMLやXMLが使われているため、これらの情報の抽出や解析に、Beautiful Soupが役立ちます。

もしPythonを扱うスキルがあれば、このライブラリと組み合わせることでかんたんにWebサイトからデータ収集を自動化することが可能です。

【こんな方におすすめ】

Webスクレイパー、プログラミングの習熟度が高い開発者

【公式サイトURL】

https://www.crummy.com/software/BeautifulSoup/

3. Import.io

【概要・特徴】

「Import.io」はWebデータプラットフォームです。Import.ioには、複数のURLクエリを処理するために特別に設計されたクロールサービスが組み込まれています。これらは動的な速度制限を利用し、エラーや制限を処理するための再試行システムを備えています。また、洞察を得るためにWebデータを販売およびマーケティングのための分析ツールに統合することができます。

複数のWebページにクエリを実行する場合、クロールサービスは、プロセスをより効率的にするために、回転するIPアドレスプールからそれぞれ非同期的にURLにクエリを実行します。さらにWebサイトの応答時間を監視し、データ抽出によってWebサイトに過剰な負荷をかけないようにしています。

【こんな方におすすめ】

データについての統合ソリューションを探している企業

【公式サイトURL】

4. ParseHub

【概要・特徴】

「ParseHub」は、ユーザーインターフェースに優れたWebスクレイピングソフトウェアです。Webサイトの任意のフィールドをクリックしてデータを抽出できます。また、IPアドレスの変更に役立つIPローテーション機能もあるため、アンチスクレイピング技術を使用しているWebサイトでもスクレイピングが実行できます。

ParseHubでは、特にチュートリアルが充実しているため、初めて使う人でも直感的に操作方法を理解できます。ただし、チュートリアルやマニュアルはすべて英語表記なので、翻訳ソフトの併用がおすすめです。

【こんな方におすすめ】

データアナリスト、マーケティング担当者、プログラミングできない研究者

【公式サイトURL】

5. CrawlMonster

【概要・特徴】

CrawlMonsterはSEOやマーケティング担当者のサイトオーディットに特化したスクレイピングツールです。シンプルなインターフェースでありながら、Webサイトのコンテンツ、ソースコードをはじめ、他にも多くのデータ分析を可能にします。

無料で使えるうえに、基本的なサイトのスクレイピングから、問題のあるページの発見などのサービスまで様々なサービスを提供。企業はオンライントラフィックの増加と収益の増加に必要なデータを得ることができます。

Webサイトを運営している企業や個人が掲げる、アクセス数増加や収益向上といった指標を改善するために必要なデータを提供します。

【こんな方におすすめ】

SEO・マーケティング担当者

【公式サイトURL】

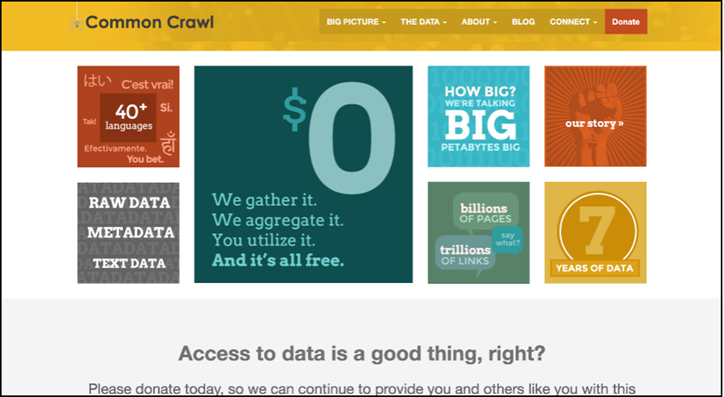

6. Common Crawl

【概要・特徴】

Common Crawlはオープンソースで提供されているスクレイピングツールです。すべての機能を無料で使える上、Webページデータ、テキスト、メタデータ抽出といったオープンデータセットを提供しています。

Common Crawlのデータは、AWS(Amazon Web Services)のPublic Data Setsと、世界中の複数のアカデミッククラウドプラットフォームに保存されているため、誰でもスクレイピングしたデータやプロジェクトを閲覧できます。

【こんな方におすすめ】

研究者、学生、教授

【公式サイトURL】

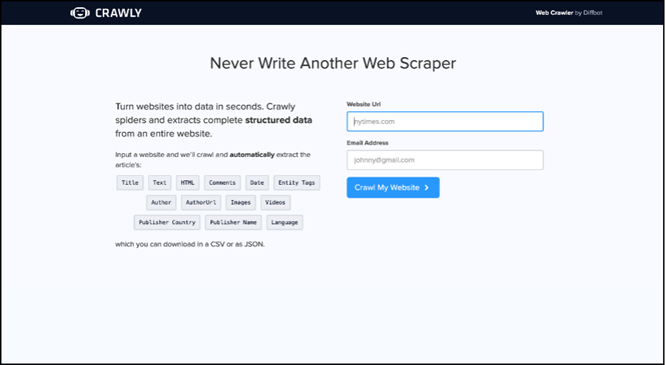

7. Crawly

【概要・特徴】

CrawlyはWebサイトをスクレイピングした結果を、JSONやCSV形式で構造化データに自動変換してくれます。細かい設定はできませんが、WebページURLを入力し抽出したい要素(例えば、HTML、コメント、DateEntityタグ、作成者、画像URL、ビデオ、発行者、国など)を選択するだけで、わずか数秒でデータスクレイピングを実行できる手軽さが魅力です。

【こんな方におすすめ】

コーディングできない基本的なデータ要件を持つ方

【公式サイトURL】

8. Sequentum

【概要・特徴】

Sequentumはエンタープライズの利用に特化したWebスクレイピングサービスです。ツールの開発、データ収集、クリーンアップの取り組みだけではなく、戦略的かつ創造的な分析に焦点を当て企業も生産性と効率性の向上に貢献します。

Sequentumのコントロールセンターには、クラウドまたはデータセンター環境内で自動化された大規模なデータ操作を実行するために必要なすべてのものが含まれています。用途・運用規模に合わせて複数の料金プランが用意されていますが、データスクレイピングの習熟度に関係なくすべてのレベルで強力な機能の標準セットが提供されます。

【こんな方におすすめ】

プログラミングに精通しているPython開発者

【公式サイトURL】

http://www.contentgrabber.com/

まとめ

今回は、Webスクレイピングに役立つスクレイピングツール8選を特徴と共に紹介しました。スクレイピングソフトを使うことで、データ収集やリスト作成に掛かる時間を大幅に短縮できるようになりました。

スクレイピングツールを使えば、プログラミングの知識やコーディングスキルがなくとも、誰でもデータ収集を効率化を実現できます。特に、リスト作成に時間を掛けているセールス担当者や、Webマーケティング担当者は、自身の業務を大幅に効率化できる可能性があるため、今回紹介したツールの中からぜひ最適なツールを見つけてみてください。