コンテンツ・アグリゲーション(Content aggregation)は、私たちの生活やビジネスシーンにあらゆる可能性をもたらすと注目を集めています。

しかし、新しいビジネスモデルだけに「そもそもコンテンツ・アグリゲーションとは何か?」と疑問を持つ方もいるでしょう。

そこで本記事では、コンテンツ・アグリゲーションの基本から実際の活用事例を紹介します。ビジネスの成功に向けた、新しいアイデアの引き出しになれば幸いです。

1.コンテンツ・アグリゲーションとは

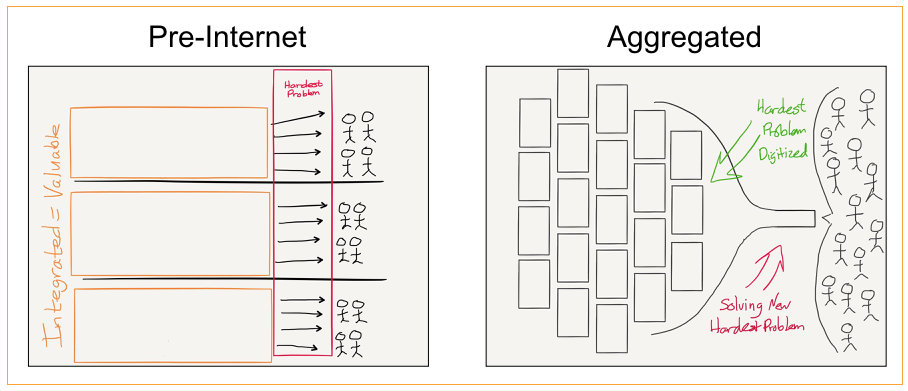

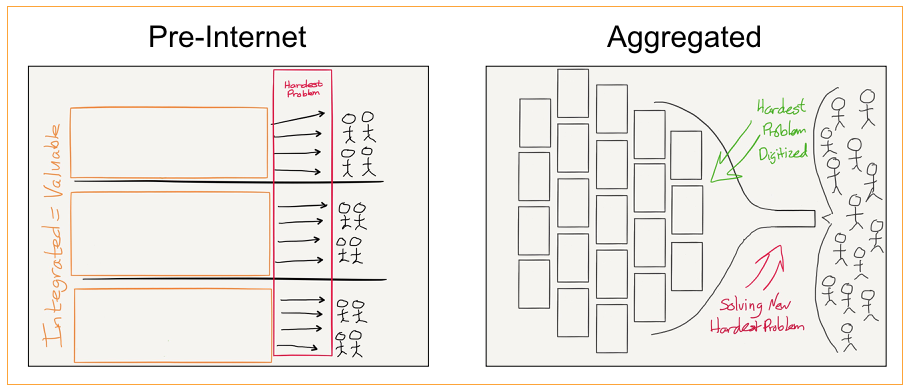

そもそもコンテンツ・アグリゲーション(Content aggregation)とは、「コンテンツを集約したサービスの総称」のことです。

アグリゲーターはコンテンツホルダーと交渉してコンテンツを収集し、各種サービスにおけるコンテンツの供給をビジネスモデルと共に提案します。その結果、各システムやデータベースに格納されているコンテンツは同一画面で閲覧できるようになります。

すでに多くの企業は、コンテンツ・アグリゲーションを活用した新たなビジネスモデルを展開しています。例えば、Google News、Yahoo!News 、Bloomberg、Smart Newsといったアグリゲーションサイトは、ユーザーに最も関連性が高いニュースをレコメンドします。

ニュースサイト以外にも、コンテンツ・アグリゲーションはあらゆるビジネスシーンで用いられています。

①センチメント分析(感情分析)

フォーラムやソーシャルメディアでレビューあるいはコメントを収集します。さらに収集された情報からテキストを抽出し、ユーザーが抱えている感情やニーズを分析します。分析によって特定された課題点やインサイト(洞察)は、品質部門に伝えられ継続的な製品改善に役立ちます。

②ニッチ市場のアプローチ

ニッチ市場とは、大規模な市場でビジネスを行うことではなく、一部の人にとって重要な狭域でのニーズ群のことです。例えば、パパ向けの子育て情報、エクストリームスポーツ、半導体・電子部品などは、特定の客層から強いニーズがあります。

ニッチ市場は明確に絞られたターゲットに対してアプローチを図る必要がありますが、コンテンツ・アグリゲーションはニッチ読者の情報ソースとして役立ちます。

③政策情報の集約

政府や政党などが施策上の方針を示す政策は、民間企業に大きな影響を与えます。こうした政府のポリシー、助成金、プレスリリースを定期的に収集・整理しているサイトがあります。これらのコンテンツホルダーが収集した政策情報をコンテンツ・アグリゲーションは一つに集約し、企業各社のニーズに応じて最適な情報を提供します。

ここで紹介したのは、コンテンツ・アグリゲーションが用いられる一部です。すでにコンテンツ・アグリゲーションは私たちの生活のあらゆるシーンで活用の幅を広げています。

2.コンテンツ・アグリゲーションのメリット

コンテンツ・アグリゲーションは、利用するユーザーとサービス提供側の双方にメリットがあります。ユーザー側にとってのメリットは、1つのWebサイトに目的の情報が集約されていることです。そのため、時間を掛けずに欲しい情報だけを効率的に収集できます。

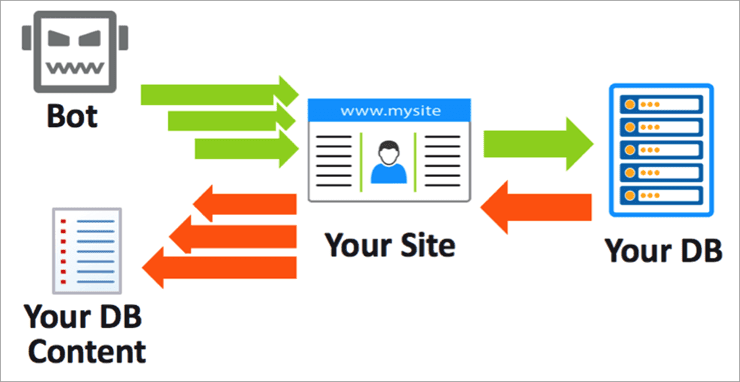

一方、サービス提供者側のメリットとしては、手間を掛けずにビジネスモデルを構築できる点が挙げられます。例えば、アグリゲーションサイトは外部サイトに掲載されている情報を、プログラムを使って自動で収集できます。つまり、コンセプトとなるサイトがあればコンテンツを自分たちで作らなくても情報をまとめて提供することができます。時間と手間をかけずに安定的に広告収益を得ることができます。

3.コンテンツ・アグリゲーションに関する課題

コンテンツ・アグリゲーションは新しい概念であるため、未来に向けて色々な可能性を秘めています。しかしコンテンツ・アグリゲーションには、ビジネス上の意思決定を行う前に考慮すべき課題もいくつか存在します。

①情報過多になりやすい

コンテンツ・アグリゲーションは、幅広いソースから情報を分別・分類する必要があります。例えば、旅行比較サイトのトラベルコは、1,500以上の予約サイトの情報を収集しています。これにより、ユーザーは複数の予約サイトを使わずとも、トラベルコひとつで、海外・国内の宿泊予約から航空券の検索・申込みまでワンストップで行えます。

しかし情報が多すぎるあまり、絞りきれないという方も少なくありません。情報量が多くなりがちなアグリゲーションサイトは、始めの段階でコンセプトとターゲットを明確にすることも必要でしょう。

また、情報過多になることでサイトを構築するソースコードの量が膨大になり、技術的な問題が発生することがあります。いくら良いアイデアであっても技術的な問題が発生した場合、実現を妨げる大きな障壁となるでしょう。

②適時性が求められる

アグリゲーションサイトにとって、情報更新の効率性は最も重要なポイントです。とりわけ常に最新の情報配信が求められるニュースサイトなどは、コンテンツ提供元から情報をより早く受け取ることが使命といえます。

それを実現するには、サイト更新と複数サイトからのデータ抽出を同時に処理する必要があります。そのためにも、情報抽出タスクのスケジューリングを事前に設定し、そこにサイト更新も合わせて行うことが必要です。

タスクのスケジューリングとは、自動的に情報を抽出するために、事前にスケジュールを設定することです。これによって、更新にかける時間と手間を省きます。ただし、タスクスケジューリングの時間を自由に設定できるわけではありません。ターゲットとなるWebサイトが情報を更新する頻度が低い場合はサーバーに余計な負担をかける可能性があります。

③同期性

システムへのシームレスな接続は欠かせません。API はサービスプロバイダーをリンクし、より高度なエンゲージメントを可能にしました。例えば、APIで取得したデータはデータベースと同期させ、WordPressのようなCMS(コンテンツ管理システム)を介してユーザーに提供できるようになります。

ほとんどのユーザーがコンテンツの「適時性」を重視しているので、データの待ち時間を最小限に抑えることが重要です。理想的にはリアルタイムの同期で転送するために、高スループット容量を持っているAPIが必要です。

4.WebスクレイピングツールOctoparseとは

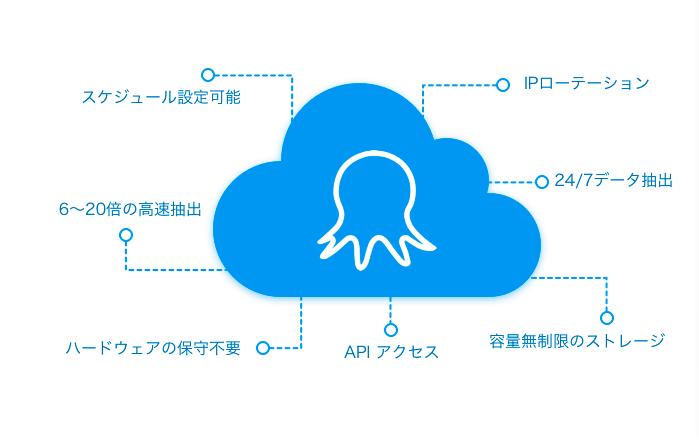

Octoparse(オクトパス)は、誰でも簡単にWebスクレイピングを実行できるクラウドソフトウェアです。これまで数多くの企業にスクレイピングサービスを提供し、情報収集や情報管理に関する課題解決に貢献しました。

ここでは、最先端のWebスクレイピングテクノロジーを備えたOctoparseの優れた特徴をいくつか紹介します。

①IT初心者でも使いやすい

Octoparseは単なるスクレイピングサービスを提供するツールではなく、インテリジェントなスクレイピングプラットフォームです。ソースコードの記述は一切不要で、WebサイトのURLをコピー&ペーストするだけで視覚的なワークフローが生成されます。

プログラミングスキルを持たない非エンジニアの方でも簡単にスクレイピングを実行できます。こうしたWebスクレイピングツールの操作に慣れると、Webスクレイピングはまるでゲームをプレイするかのように身近なものになります。

②クラウドでのタスクスケジューリングと並列抽出

Octoparseは、クラウドサーバーでWebスクレイピングを実行できます。これによってデータ抽出作業がさらにスピーディになります。ただし、あらかじめ以下の2つのステップが必要です。

- スクレイピングタスクのスケジューリングを行います。更新のタイミングを設定したら、これと更新の頻度が近いタスクをグループ化して、それぞれのタスクを並列抽出できます。これによりスクレイピングプロセスをより簡単にモニタリングできます。

- Octoparseには無制限のアドオンクラウドサーバーが備わっており、あらゆるスクレイピングニーズに対応します。一般的にサーバーが増えるとスクレイピングタスクで作業するプロセッサが増えます。集約スコープが上限に達すると、ニーズに合わせてサーバーを拡張できます。

タスクのスケジューリングと並列抽出は、企業レベルの情報抽出に最適な組み合わせです。これらのギアセットを実装すると、300を超えるWebサイトから毎日何百万ものデータ抽出を簡単に実行できます。

③データ抽出はほぼリアルタイムと同期

OctoparseはAPIを統合した時点で、スクレイピング(データ抽出)と同時にエクスポートを実行します。これにより、2つのエンドポイント間でリアルタイムに同期が可能になり、データ抽出に掛かる手間が大幅に効率化されます。

現在Octoparse APIは、SqlServer、MySql、Oracleの3つのデータベースをサポートしています。リアルタイムのデータ取得に関して詳しく知りたい方はこちらの記事もご覧ください。

まとめ

コンテンツ・アグリゲーションには、データ抽出を自動化するWebスクレイピングが欠かせません。今回紹介したOctoparseの機能は、コンテンツ・アグリゲーションで新しいビジネスを始める上で、大いに役立つでしょう。

コンテンツ・アグリゲーションやビッグデータの活用は世の中をより便利にします。Octoparseのような最先端のデジタルツールと、自分たちの強みを掛け合わせることで、ぜひビジネスチャンスにつなげてください。もしデータ収集やデータ活用でお悩みがありましたら、Octoparseのサポートまでお気軽にお問い合わせください。