ビジネスの現場やマーケティング業務において、「Web上の情報をExcelに取り込みたい」と感じたことはありませんか?たとえば、競合サイトの価格情報や商品リスト、公開データベースの情報など、手作業でコピー&ペーストするのは時間がかかり非効率的です。

本コラムでは、Web上のデータをExcel内にインポートする具体的な手順から、データ収集を効率化するツールまでわかりやすく解説します。業務の効率化やデータ活用の第一歩として、ぜひ参考にしてください。

WebからのデータをExcelにインポートする方法

Web上には日々膨大なデータが公開されており、それらを業務で活用するには「いかに効率よくデータを取り込むか」が重要なポイントです。特にExcelは、多くの企業で使われているため、WebデータをそのままExcelに取り込めれば、集計や分析のスピードが飛躍的に向上します。

ここでは、初心者でも取り組みやすい「Excelの組み込み機能」や「Power Query(パワークエリ)」を使ったデータ取り込みの方法について、順を追って解説します。

Excelの組み込み機能を使用したWeb取り込み

Web上のランキング情報や表形式のデータを簡単にExcelに取り込むには、「ExcelのWeb取り込み機能」が便利です。

コピー&ペーストでもデータを取り込むことは可能ですが、表が崩れてしまうことも多いため、データの整理に工数が掛かります。手間を掛けずに、データを取り込むには「組み込み機能」を使うと良いでしょう。

具体的な手順は以下の通りです。

- Excelの「データ」タブを開きます

- 「データの取得」または「データを取得」をクリックします(Excel 2021/Microsoft 365では「データを取得」)

- 表示されたメニューから「Webから」を選択します

- 表示されたダイアログボックスに取り込みたいWebページのURLを入力して「OK」を押します

- ナビゲーター画面で取り込みたいテーブルを選択します

- 「読み込み」を選択してデータをExcelに取り込むか、「データの編集」を選択して取り込む前にデータを加工することができます

この方法を使えば、Webページにある複数のテーブルから必要なデータだけを選択して、整った形でExcelに反映させることが可能です。また、「更新」機能を使えば、元データが更新された場合にExcel側のデータも自動的に再取得できます。

しかし、Excelのバージョンによって操作方法やメニュー名が若干異なる場合があります。Excel 2013以前では操作方法が大きく異なり、「Webから」機能の場所や表示が変わっている可能性があります。

Power QueryによるWebデータの抽出と変換

Excelに搭載されている「Power Query(パワークエリ)」は、Web上の構造化データを抽出・変換し、効率よくExcelに取り込むための強力なツールです。データの整形や加工が簡単にできるため、定期的に更新されるデータを扱いたい場合に特に効果を発揮します。

Power Queryでデータを取り込む手順(Excel 2016以降):

- Excelの「データ」タブを開き、「データの取得」または「データを取得」をクリックします

- 表示されたメニューから「Webから」を選択します

- URLを入力するダイアログが表示されるので、取り込みたいWebサイトのURLを入力し「OK」をクリックします

- ナビゲーター画面で取り込みたいテーブルやデータを選択します

- 「データの編集」をクリックすると、Power Query Editor(パワークエリエディタ)が開き、データの整形や加工が行えます編集が完了したら「閉じて読み込む」をクリックして、Excelシートにデータを取り込みます

大規模データをExcelにインポートする手法

これまで紹介した「Excelの組み込み機能」や「Power Query」は、シンプルなWebページや比較的小規模なデータの取り込みには非常に便利です。しかし、数千件・数万件といった大規模なデータを対象とする場合、処理速度や自動化の面で限界を感じることもあります。

また、動的に表示されるページ(JavaScriptで生成される情報など)では、Power Queryでは正しく情報を取得できないケースも少なくありません。そうした場合には、専用のスクレイピングツールや外部リソースの活用(アウトソーシング)が効果的です。

以下では、それぞれのアプローチについて詳しく解説します。

ウェブスクレイピングツールを利用する

大規模なWebデータを効率よくExcelに取り込むには、ウェブスクレイピングツールの導入が非常に有効です。ウェブスクレイピングとは、Webサイト上の情報を自動で収集・抽出する技術で、手作業では対応が難しい大量のデータにも対応できます。

特に、以下のような用途で活用されています。

- ECサイトの商品情報・価格情報の一括取得

- 不動産・求人情報などの一覧収集

- 定期的なデータモニタリング(競合分析など)

ウェブスクレイピングの基本については、こちらもご覧ください。

アウトソーシング(外注)サービスを活用する

- ランサーズ:日本最大級のクラウドソーシングプラットフォームです。データ収集・スクレイピング経験者が多く登録しており、業務内容を相談しながら依頼できます。

- クラウドワークス:IT・マーケティング関連の案件が豊富で、スクレイピングやデータ入力を専門にするワーカーも多く登録しています。予算や納期の調整も柔軟に対応可能です。

- ココナラ:知識・スキルのフリーマーケットサービスで、さまざまなサービスが出品されています。スクレイピングやExcel加工のサービスがあらかじめ商品化されており、希望に近いパッケージを選んで購入する形式です。

Octoparseを活用したExcel向けデータ収集

ノーコードで利用できるスクレイピングツールとして、多くのユーザーに支持されているのが Octoparse(オクトパス) です。特に「Excelでのデータ分析を効率化したい」「Web上の大量データを定期的に収集したい」という方にとって、Octoparseは非常に強力な武器となります。

Octoparseとは?

Octoparseは、プログラミング不要でWebサイト上の情報を自動で抽出・収集し、ExcelやCSV、JSONなどの形式で出力できるクラウド型のスクレイピングツールです。

特徴的なのは、GUI操作だけで複雑なデータ構造や動的コンテンツにも対応できる点。テンプレート機能も備えており、初心者でも数クリックでスクレイピングを開始できます。

参考:Octoparse公式ブログ – WebサイトからデータをExcelに取り込む方法

基本的な使い方の流れ

ここでは、美容院・ヘアサロンの検索・予約サイト「ホットペッパービューティー」の掲載データを、Octoparseを使って自動収集する方法を解説します。

ステップ 1. スクレイピングテンプレートを選択する

Octoparseでは、人気の高いWebサイトのスクレイピングテンプレートが用意されています。スクレイピングしたいWebサイトがあれば、テンプレートを検索して見つけることができます。

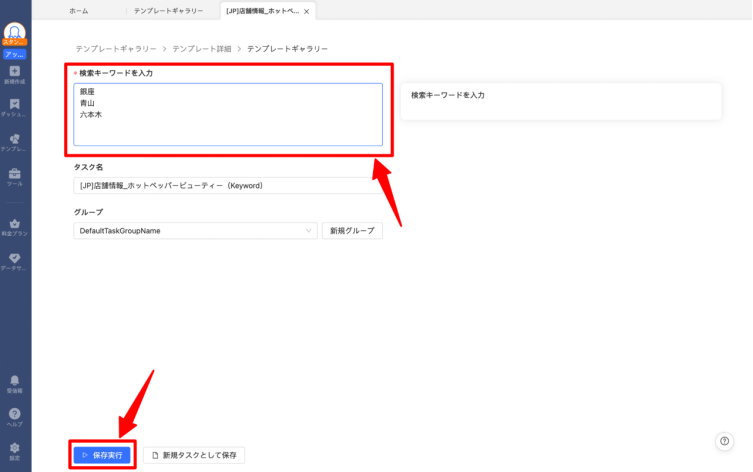

Octoparseにログインしたら、テンプレートギャラリーより「ホットペッパー」と入力しましょう。いくつかテンプレートが表示されるので、「店舗情報_ホットペッパービューティー(Keyword)」を選択します。

ステップ2.スクレイピングしたいデータを抽出する

次に、どんなデータを抽出するかを伝えます。ホットペッパービューティーのテンプレートでは、キーワードを入力する欄があるので、そこに任意のキーワードを打ち込みます。

ここでは、「銀座」「青山」「六本木」と入れてみます。入力が完了したら「保存実行」を押しましょう。

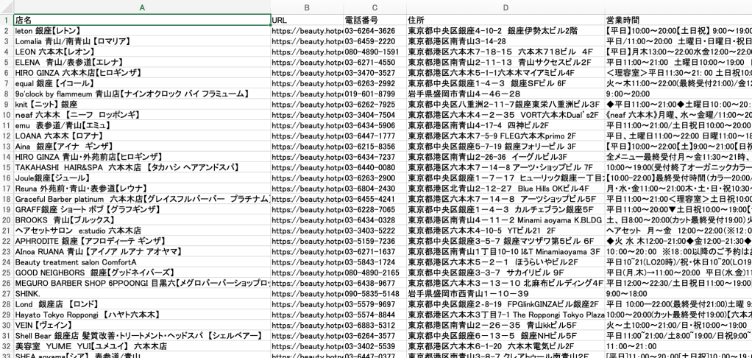

スクレイピングタスクの実行が完了し、以下のようにデータ抽出が開始されていれば問題ありません。すべてのデータ抽出が完了するまで、数分程度待ちましょう。

ステップ 3. スクレイピングデータを Excel にダウンロードする

すべてのデータ抽出が完了したら、スクレイピングデータを任意の形式にエクスポートできます。その中にExcelがあるので、そちらを選択してエクスポートを開始します。

店舗名、住所、電話番号、営業時間といった、美容サロンの情報を自動で収集することができました。このようにOctoparseを使えば、任意のWebサイトから欲しい情報を自動で抽出し、Excelでダウンロードすることが可能です。

まとめ

Web上のデータをExcelに取り込む際は、手作業のコピー&ペーストを行うのではなく、Excelの組み込み機能やPower Queryを使うことで、データ取得の手間が大幅に少なくなります。一方、大規模かつ定期的なデータ取得が必要な場合は、Octoparseのようなスクレイピングツールや、クラウドソーシングによる外注を活用すると良いでしょう。

規模や目的にあわせて、ツールや外部リソースを使い分けることで、業務のスピードと正確性が飛躍的に向上します。データ活用の第一歩として、まずは自社のニーズに合った取り込み方法から試してみてください。

ウェブサイトのデータを、Excel、CSV、Google Sheets、お好みのデータベースに直接変換。

自動検出機能搭載で、プログラミング不要の簡単データ抽出。

人気サイト向けテンプレート完備。クリック数回でデータ取得可能。

IPプロキシと高度なAPIで、ブロック対策も万全。

クラウドサービスで、いつでも好きな時にスクレイピングをスケジュール。