WebマーケティングやSEO対策を進める際、ページ内のURL一覧を効率的に収集することは非常に重要です。特に、競合サイトのURL構造を把握したり、サイト全体の内部リンクを管理したりするためには、URLの一括抽出ツールが役立ちます。しかし、数あるツールの中からどれを選ぶべきか迷う方も多いでしょう。

今回は、Webページ内のURLを一括で取得し、データとして活用できるおすすめのURL抽出ツールを5つご紹介します。さらに、具体的な活用方法やツール選びのポイントについても詳しく解説していきます。

WebページからURL抽出した後の活用方法

WebページからURLを抽出するだけでなく、そのデータをどのように活用するかによって、マーケティングの成果も大きく変わります。ここでは、URLを効果的に活用するための具体的な方法について解説します。

内部リンクの最適化

Webページから取得したURLデータは、内部リンクの最適化に活用できます。内部リンクは、ユーザーの回遊性を高めるだけでなく、検索エンジンにとっても重要な指標です。効果的なリンク構造を作り、検索順位を上げるための基礎として、まずはページ内の全URLを把握しましょう。

競合サイト分析

競合サイトからURLを抽出することで、他社のページ構造やコンテンツ戦略を把握することができます。競合の内部リンクやコンテンツのカテゴリーを調査し、自社サイトの改善ポイントを見つけるための貴重なデータとなります。また、特定のコンテンツページへのリンクが多い場合、そのページがトラフィックを集めている可能性もあります。

コンテンツ管理と更新

自社サイト内のURL一覧を定期的に取得することで、コンテンツ管理や更新が効率的に行えます。古くなったページやリンク切れを発見しやすくなり、ユーザーの利便性を向上させると同時に、SEO対策としても効果的です。また、URLデータはサイトマップの作成や更新時にも活用でき、検索エンジンへのインデックス促進に役立ちます。

外部リンクのチェックと精査

URL抽出ツールを使って外部リンクの一覧を取得し、リンク先の信頼性や関連性を確認することで、SEO効果の向上を図れます。不適切な外部リンクはユーザーの信頼を損なうだけでなく、検索エンジンからの評価にも影響するため、定期的なチェックが欠かせません。また、有用な外部リンクを適切に配置することで、ユーザーに価値のある情報を提供できます。

URL取得ツールの選び方

URL取得ツールはさまざまな種類がありますが、選ぶ際には目的や使用シーンに応じた適切な機能を持ったツールを選ぶことが大切です。ここでは、URL取得ツールを選ぶ際に注目すべき主なポイントについて解説します。

一括URL取得機能

まず、効率的にURLを収集するためには、一括でURLを取得できる機能が重要です。この機能により、複数のWebページやドメイン全体からURLを一度に抽出でき、時間と労力を大幅に削減できます。特に大規模サイトや複数のWebページを対象にする場合には、必須の機能と言えるでしょう。

データ出力形式

取得したURLデータを効果的に利用するためには、データの出力形式も重要です。例えば、CSVやExcel形式での出力が可能なツールであれば、後でデータを整理・分析しやすくなります。JSONやXML形式に対応している場合、他のシステムやアプリケーションと連携しやすくなるため、使い勝手が向上します。自分の業務に適した出力形式をサポートしているか確認しましょう。

処理速度と安定性

URLを大量に抽出する際、ツールの処理速度と安定性は非常に重要です。処理速度が遅いと業務効率が低下し、大規模なWebページのデータ取得には時間がかかってしまいます。また、安定性に欠けるツールは、途中でエラーが発生したり、処理が中断されるリスクがあります。スムーズな作業を進めるためにも、速度と安定性の高いツールを選びましょう。

カスタマイズ性

URL抽出ツールの中には、カスタマイズ機能が充実しているものもあります。特定のURLパターンや条件で抽出を絞り込める機能があれば、自分の目的に合わせて効率的にデータを集めることができます。また、フィルター機能やクロール設定を細かく調整できるツールは、特定のニーズに合わせた高度なデータ取得が可能です。業務の目的に応じて、カスタマイズ性があるかを確認すると良いでしょう。

価格と費用対効果

ツールを導入する際には、価格とその費用対効果も重要なポイントです。無料で提供されているツールもありますが、機能が限定されている場合もあります。一方、有料ツールは高度な機能やサポートが充実しており、大規模なプロジェクトや継続的なデータ抽出に向いています。自社の予算やニーズに合った費用対効果の高いツールを選ぶことが、長期的なコスト削減につながります。

おすすめURL抽出ツール5選

ここからは、具体的におすすめのURL抽出ツールを5つ紹介します。それぞれのツールの特徴やメリットを比較し、自分に最適なものを見つける際の参考にしてください。

Octoparse

Octoparseは、ノーコードでWebデータを収集できる強力なデータスクレイピングツールです。多機能で直感的なインターフェースを備えており、初心者から上級者まで幅広いユーザーに対応しています。

- 一括URL取得が簡単で、複雑なWebサイトからもデータを効率的に抽出可能

- データ出力形式が豊富(Excel、CSV、API連携など)

- クラウドサポートにより、複数のデバイスからのアクセスとプロジェクトの管理が可能

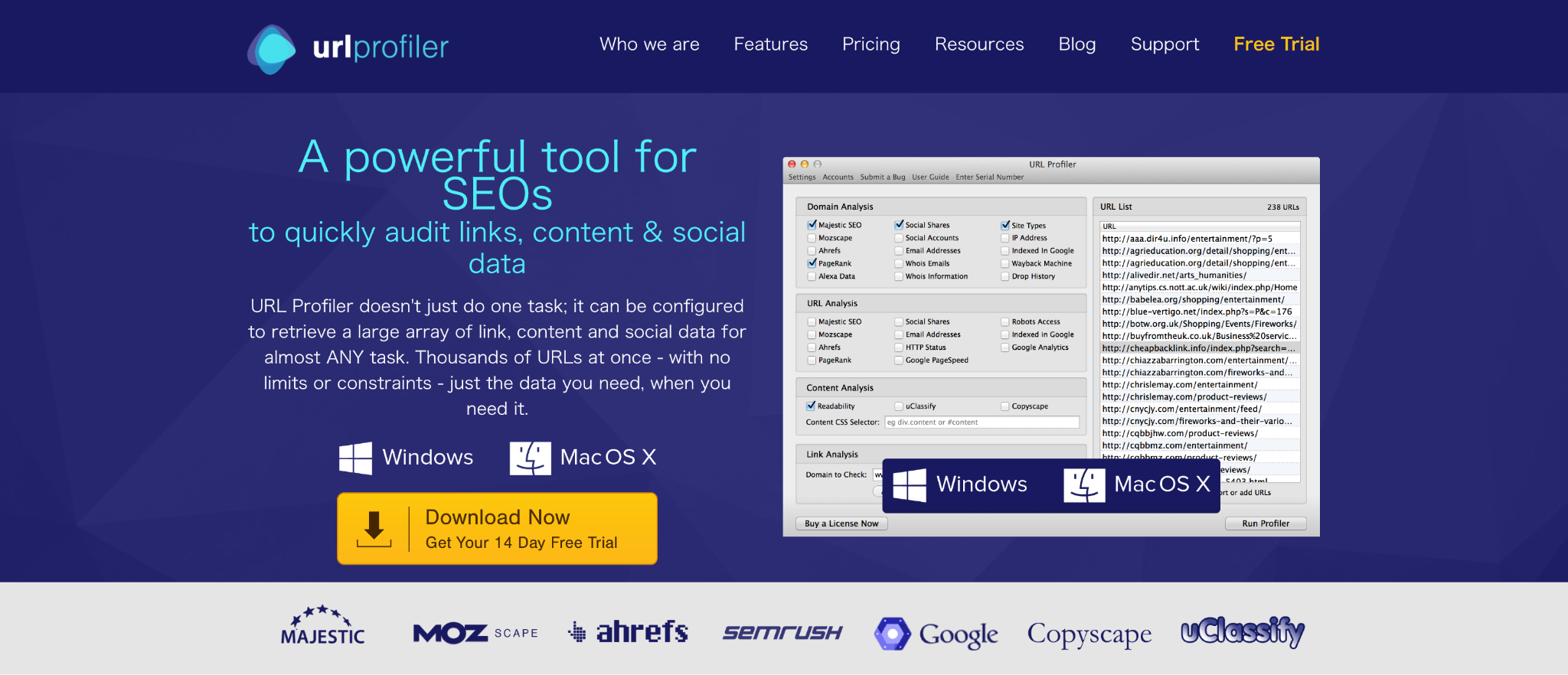

URL Profiler

URL Profilerは、SEOやコンテンツマーケティングに特化したURL抽出ツールで、競合分析やリンクプロファイルの精査に適しています。多機能でプロフェッショナル向けのツールです。

- SEOデータの自動取得が可能で、リンクデータだけでなく、コンテンツやSNSシグナルの情報も収集

- データのエクスポート形式が多様で、簡単にレポート化できる

- 大規模データの処理に強く、複数のURLを短時間で分析可能

Link Extractor

Link Extractorは、Google Chromeの拡張機能として利用できる軽量なURL抽出ツールで、手軽にWebページ上のリンクを抽出できる点が魅力です。

- ブラウザ上で簡単に操作でき、インストール後すぐに使える

- シンプルなインターフェースで、特定のWebページ内の全リンクを瞬時に抽出可能

- 無料で利用でき、個別のページ分析に適したツール

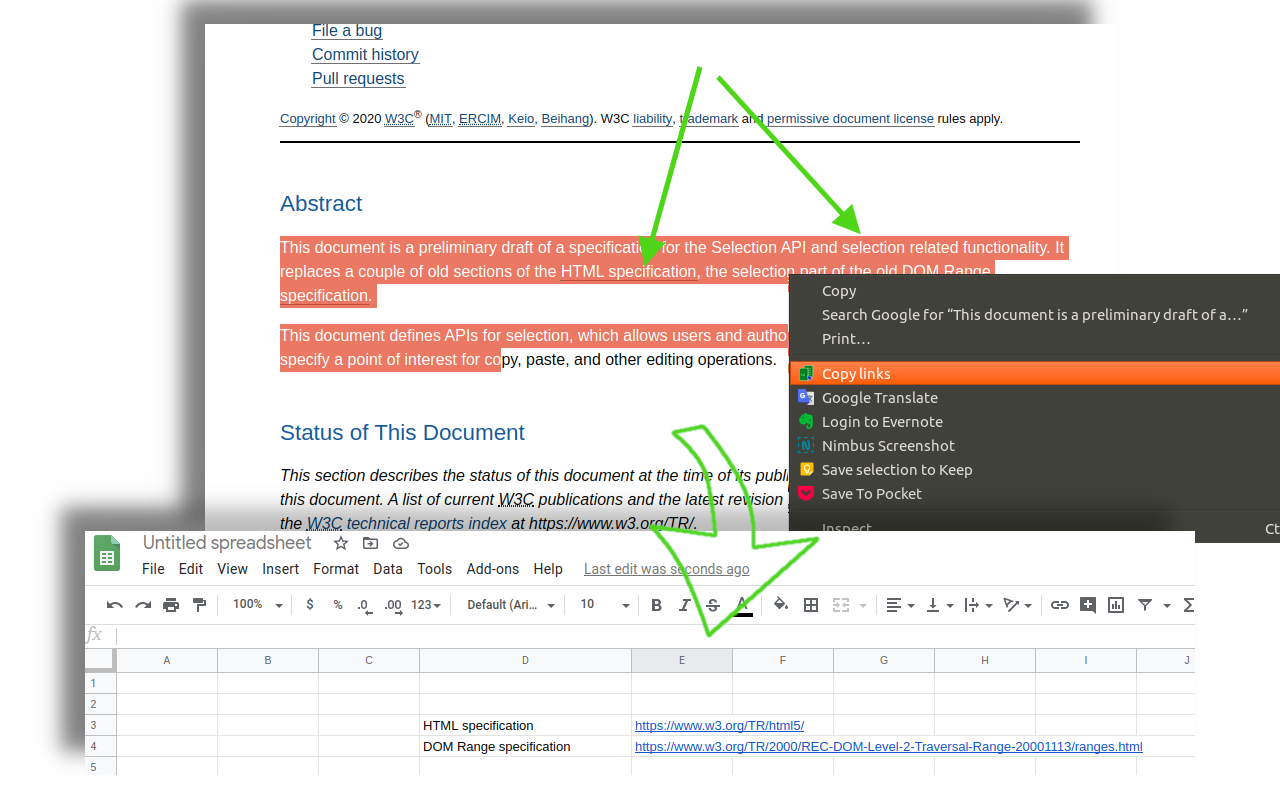

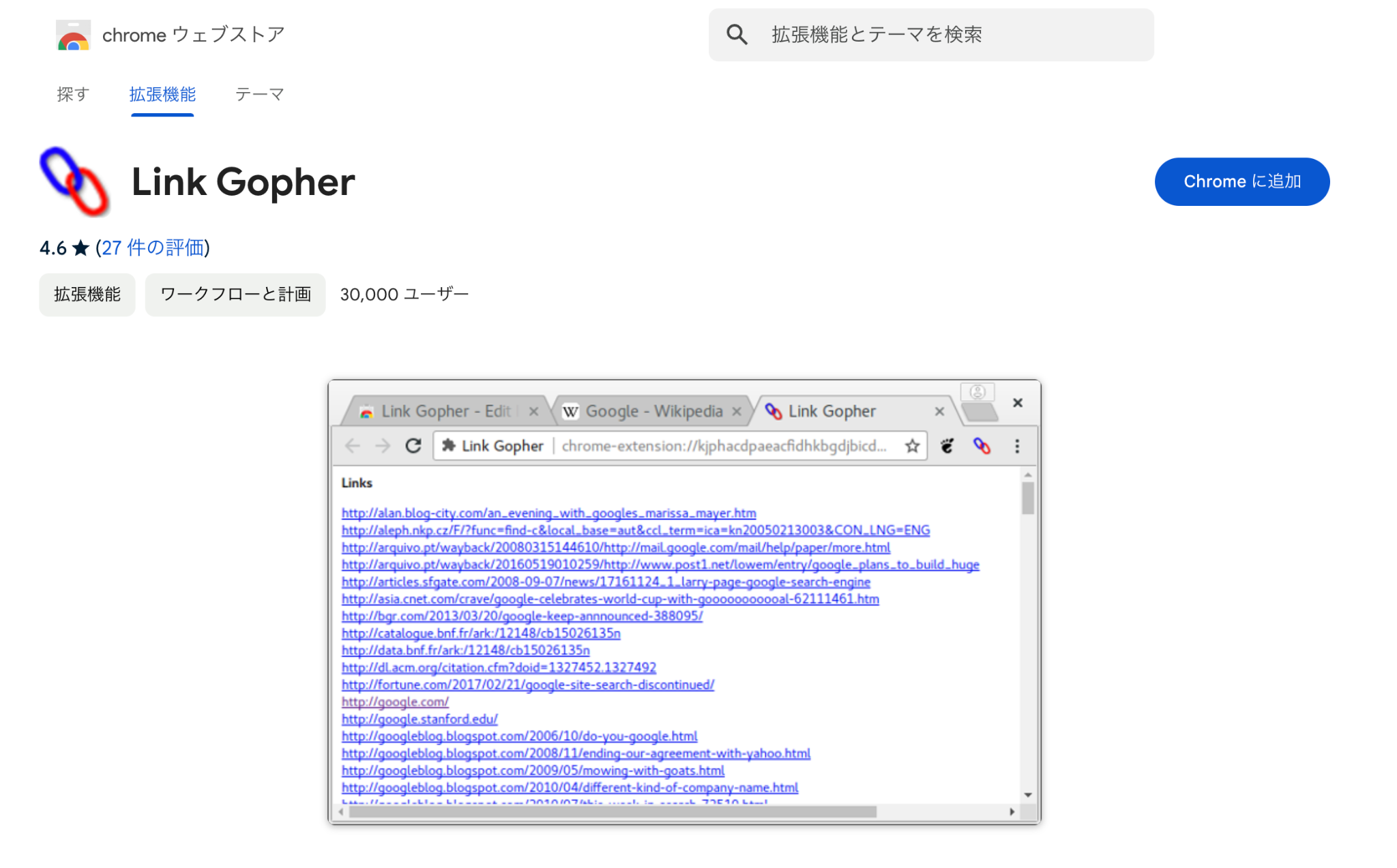

LinkGopher

LinkGopherは、Chrome拡張機能として提供されるシンプルで使いやすいURL抽出ツールで、特に内部リンクや外部リンクの整理に適しています。

- ページ内のリンクを分類して表示し、内部リンク・外部リンクの確認が容易

- 抽出したURLをテキスト形式で出力でき、データの転送が簡単

- 軽量で無料のため、気軽に導入できる

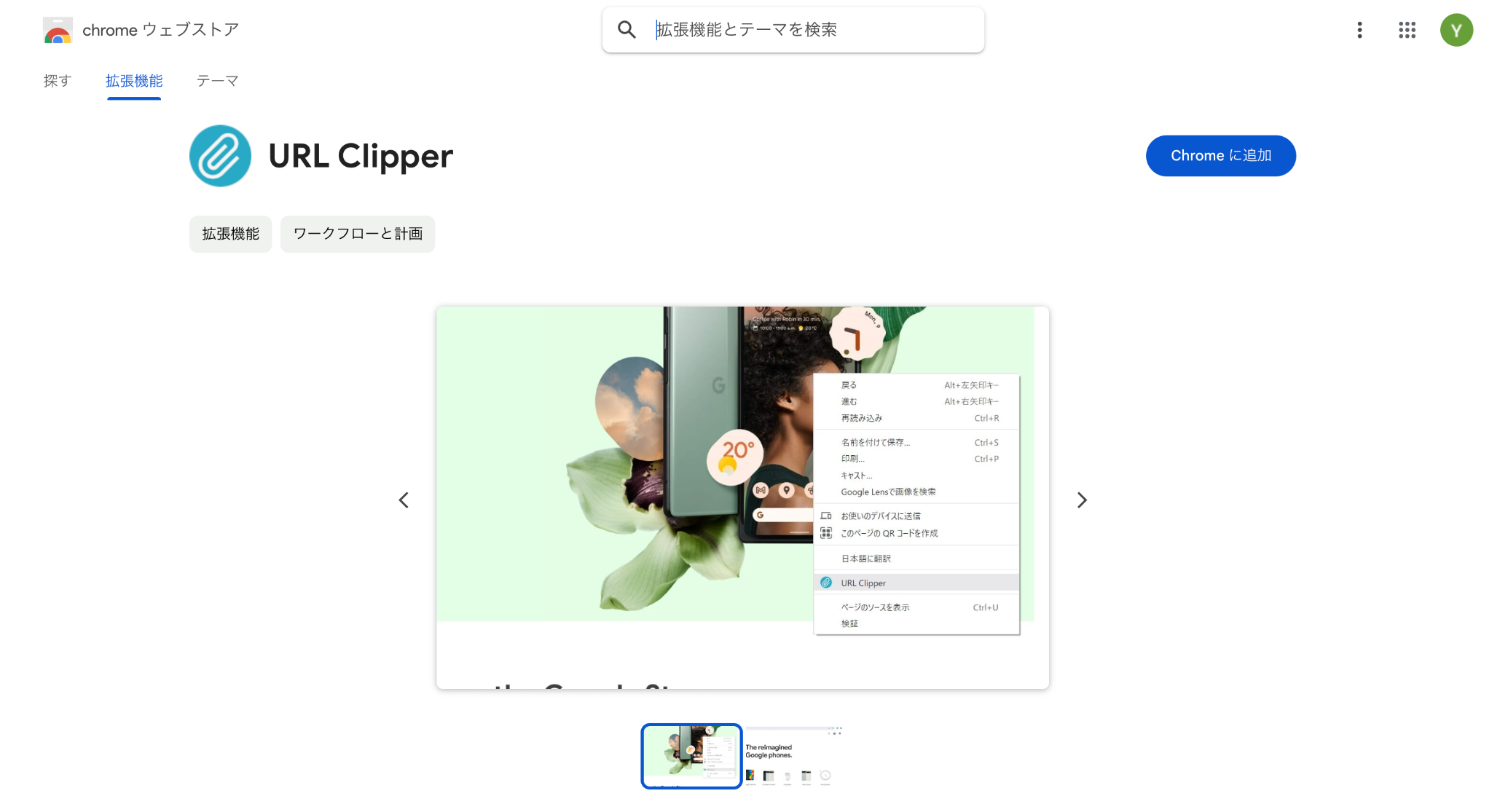

URLクリッパー

URLクリッパーは、シンプルながら実用性の高いChrome拡張機能で、簡単にページ内のURLを収集できるツールです。個別のページのリンク収集に適しています。

- ページ内のURLをワンクリックでコピーでき、手間なくリンクを収集可能

- 重複するURLを自動で除外する機能があり、無駄のないデータ取得が可能

- 完全無料で使用でき、ブラウザに追加するだけで簡単に使える

Pythonでサイトのリンク一覧を取得する方法【URL取得コード例付き】

URL抽出ツールを利用する以外にも、Pythonを使ってプログラムを組むことで、特定のサイトからリンク一覧を取得する方法があります。Pythonの「BeautifulSoup」や「Requests」ライブラリを使うことで、カスタマイズ性の高いデータ収集が可能です。以下は「BeautifulSoup」を用いたリンク抽出スクリプトです。

コードのポイント

- requestsライブラリで指定したURLにHTTPリクエストを送り、HTMLデータを取得。

- **BeautifulSoup**でHTMLをパースし、ページ内のリンクを解析。

- soup.find_all(‘a’)でページ内の全ての<a>タグを抽出し、そのhref属性を取得。

まとめ

URL抽出は、WebマーケティングやSEO対策において効果的な手段であり、活用方法次第でさまざまなデータ分析や戦略立案に役立ちます。今回ご紹介したおすすめのツールや、Pythonでの実装方法を参考に、自分に最適な方法でURLデータを取得し、ビジネスに活かしてみてください。適切なツールを選ぶことで、作業効率が向上し、データ活用の幅も広がるでしょう。